Deepfake veszélyei

Deepfake veszélyei : hogyan vernek át AI-generált hanghívásokkal és mit tehetsz ezek ellen❓

A deepfake veszélyei a technológia fejlődése által, ma már nem csupán videók manipulálásánál jön elő. A csalók képesek teljesen valósnak tűnő telefonhívásokat létrehozni. Ezekben például egy mesterségesen generált hang hitelesen utánozza egy vezető, ügyintéző vagy hivatalos személy kommunikációját.

Nem a hangban, hangszínben van mindig a lényeg, hanem a mélyhamisítás folyamata játssza a kulcsszerepet

A veszély nem magában a hangban rejlik, hanem abban, hogy a támadók olyan helyzetet teremtenek, amelyben a hívás minden eleme a stílus, a sürgetés, a kontextus valódinak tűnik. Ez a fajta mélyhamisítás már nem szimplán technikai trükk, hanem pszichológiai támadás, amely a bizalomra és a döntési reflexeinkre épít.

Szerencsére keresztnevemnek köszönhetően, személy szerint rám nincs hatással, hisz kételkedek, ellenőrzök, mindig. 😉 De 💭 gondolataim másoknak a deepfake veszélyei témában hasznosak lehetnek.

📣 Nézzük hát meg, hogyan használják a pénzügyek világában a csalók a mélyhamisítás opcióját a telefonos átverések során, amit a technológiai alapok lehetővé tesznek számukra. S milyen lépésekkel lehet felismerni és kivédeni ezeket a manipulációkat 👇

Mik a deepfake veszélyei a modern pénzügyek világában❓

A deepfake technológia a pénzügyi szektorban nem egyszerűen egy újabb technikai kihívás, hanem egy olyan rendszerszintű fenyegetés, amely alapjaiban forgatja fel azt, ahogyan a bankok, vállalatok és ügyfelek kommunikálnak egymással. A modern pénzügyek világa, melyről blogom eme szeglete szól, nagyrészt bizalmon, hitelesítési folyamatokon és gyors döntéshozatalon alapul. Nem szeretnék elkalandozni, de azért fontos ezen a ponton kiemelnem, hogy milyen káros a kapitalista rend által kitermelt rohanó életmód. Az idő pénz szemlélet sajnos meggondolatlan döntéseket is eredményezhet.

✅ Szóval említett három pont, amelyekre a deepfake veszélyei célzottan hatnak, ezért is pedzettem, hogy bizony pszichológiai hadviselés mindez❗

A pénzügyi csalók nemcsak a technológiát használják „okosan”, hanem inkább magát az emberi tényezőt. A reflexeket, a hierarchiához való viszonyulást, a sürgetésre adott automatikus reakciókat és azt a sajnos korántsem naiv feltételezést használják ki, hogy egy hivatalosnak tűnő kommunikáció valódinak tűnik az áldozatnak.

A deepfake veszélyei tehát nemcsak abban rejlenek, hogy egy hang vagy arc mesterségesen előállítható, hanem abban, hogy a támadók képesek olyan helyzetet teremteni, amelyben a hamisított kommunikáció teljesen beleillik a pénzügyi folyamatok megszokott ritmusába. A modern pénzügyek gyorsasága, digitalizáltsága és a távoli, csatornákon átívelő kommunikációja miatt a deepfake‑alapú támadások ma már nem kivételes esetek, hanem egyre gyakoribb, egyre kifinomultabb fenyegetések, amelyekre minden szereplőnek fel kell készülnie.

Mi az a deepfake hanghívás és miért veszélyes❓

A deepfake hanghívás nem más, mint egy mesterségesen létrehozott, valódinak tűnő telefonos kommunikáció, ahol a támadó egy generált hangot használ arra, hogy egy konkrét személy szerepébe bújjon. A lényeg nem a hang minősége, hanem az, hogy a hívás minden eleme a megszólítás, a stílus, a ritmus, maga a kontextus azt az érzetet keltse, hogy egy valódi, ismert vagy hivatalos személy beszél velünk. A deepfake hanghívás tehát egy olyan manipulációs eszköz, amely a hitelesség látszatát teremti meg egy teljesen hamis kommunikációs helyzetben.

💣A csalók gyakran küldenek:

- spoofolt e‑mailt (hamisított feladói cím, például a „főnök” nevében),

- hamis Teams/Slack üzenetet,

- SMS‑t vagy WhatsApp‑üzenetet,

- vagy alternatív utakon egy „előzetes tájékoztatást”, amely megágyaz a későbbi hívásnak.

Ezek az előzetes lépések azért működnek, mert pontosan az emberi agy működési modelljére építenek. Az emberi agy, mindig keresi a számára pihenést, hívhatjuk ezt üres ciklusnak. Ezért van az, hogy bizalmat kelt az emberekben, ha mondta valaki, vagy már látta valahol.

✅ Ezek képként tárolódnak az emberi agyban és megnyugtató hatásúak❗

Ezért veszélyes leginkább

A deepfake veszélyei között pedig egy deepfake hanghívás azért tud eredményes lenni, mert az áldozat már nem kérdőjelezi meg, hiszen „úgyis írtak róla” kép rögzül az agyában. Itt jegyezném még meg, hogy általában az üzenet és a hanghívás nem egy napon zajlik. Egy – két nap elteltével ugyanis, ha az áldozatban volt is éberség, az már elillan, csak az addig letárolt információ megnyugtató képe marad meg benne.

Tehát mindez egy többlépcsős manipulációs folyamat része, amelynek célja, hogy a hamis kommunikáció teljesen beleolvadjon az áldozat megszokott munkafolyamatába, mondjuk ki nyíltan, a napi rutinba. S itt a rutin szóban van a lényeg. Mert ismétlem magam újfent, az emberi agy szereti a pihenést, ezért vannak dolgok amit rutinszerűen, gondolkodás nélkül ellát. Ilyen például egy autóban (manuális váltósnál) a sebességváltás folyamata. Ha szurok sötét is van az autóban, az megy, nem kell oda az agy nagyobb százalékú aktivitása.

Hogyan működik Ai hangklónozás technológia a deepfake veszélyei között❓

Mielőtt az olvasóm belebonyolódna a dolgokba, szeretném tisztázni ennél a résznél viszont már maga a hang számít. Úgy gondolom a legjobb, ha egy apróbb táblázatban két jelenséget a deepfake veszélyei között elkülönítek egymástól. Így már rögtön az elején ki tudom küszöbölni a félreértések lehetőségét.

📱Mobilon ↔️irányba a lenti táblázat görgethető ⬇️

| Fogalom | Mi ez? | Mire jó? | Kapcsolat |

|---|---|---|---|

| Ai hangklónozás | Technológia | Hang lemásolása | Eszköz, amit a támadó használhat |

| Deepfake hanghívás | Támadási módszer | Teljes kommunikációs helyzet hamisítása | Használhat hangklónozást, de nem ez a lényege! |

10–20 másodperc hangminta is elég az Ai hangklónozás számára

A modern Ai hangklónozás rendszereinek legaggasztóbb tulajdonsága, hogy már egészen minimális hanganyagból is használható modellt tudnak építeni. Míg néhány éve még percekig tartó, tiszta hangfelvételre volt szükség, ma már 10–20 másodperc is elegendő ahhoz, hogy a rendszer felismerje és reprodukálja egy ember hangjának legfontosabb jellemzőit. Ez a gyakorlatban azt jelenti, hogy egy rövid videó, egy hangüzenet, egy interjú részlete vagy akár egy véletlenül rögzített telefonhívás is elég alapot adhat a támadóknak.

A kevés hangminta azért is különösen veszélyes, mert a legtöbb ember nem védi tudatosan a saját hangját. A közösségi médiában, a munkahelyi meetingeken, a videóhívásokban vagy akár egy ügyfélszolgálati beszélgetésben rengeteg olyan rövid részlet keletkezik, amelyet a támadók könnyedén felhasználhatnak.

A deepfake veszélyei táplálásához olyan ez, mint egy megterített asztal egy éhes csordának!

Viszont a technológia fejlődése miatt ma már nem a hangminőség a döntő tényező, inkább az, hogy a rendszer képes legyen felismerni a beszéd egyéni mintázatait, és ehhez már meglepően kevés adat is elég.

A hang érzelmeit, hangsúlyát is másolja az AI

A modern Ai hangklónozás rendszerei már nemcsak a hangszínt és a beszéd ritmusát képesek reprodukálni, hanem azokat a finom érzelmi és prozódiai mintázatokat is, amelyek egy ember beszédét egyedivé teszik. Az AI felismeri, hogyan változik a hang magassága izgatottságkor, milyen tempóra vált sürgetésnél, hogyan ejti a beszélő a hangsúlyos szótagokat, és milyen apróbb szüneteket tart gondolkodás közben.

Ezeket a mintákat aztán beépíti a generált hangba, így a végeredmény nemcsak hasonló, hanem megtévesztően hiteles érzelmi tónusú lesz. Ez az érzelmi utánzás az, ami miatt az Ai hangklónozás végterméke maga a hang, sokszor már természetesebbnek hat, mint egy egyszerűen „lemásolt” hangszín.

Nem kell ismert hang, elég egy „vezetői tónus”

A támadóknak sokszor még az Ai hangklónozás nagyon precíz megoldására sincs szükségük. Az esetek többségében bőven elég, ha a különböző AI alapú megoldásokkal, egy olyan általános „vezetői tónust” generálnak, amely magabiztos, határozott és sürgető.

A legtöbb ember ugyanis nem a konkrét hangszínt ismeri fel elsőként. Mivel ott legbelül aranyos kis engedelmes lélek, hiszen az agyának arra van szüksége, a pihenés miatt, hogy más megmondja mit csináljon, elsőként a kommunikációs szerep fogja az áldozatot betalálni. Az áldozat számára az lesz lényeges, hogy valaki főnökként, döntéshozóként vagy autoritásként szól hozzá.

Ezért működnek azok a deepfake hanghívások is, ahol nem a hang tökéletes másolata, vagy bármilyen másolata a lényeg, hanem elég „vezetői” ahhoz, hogy az áldozat reflexből engedelmeskedjen.

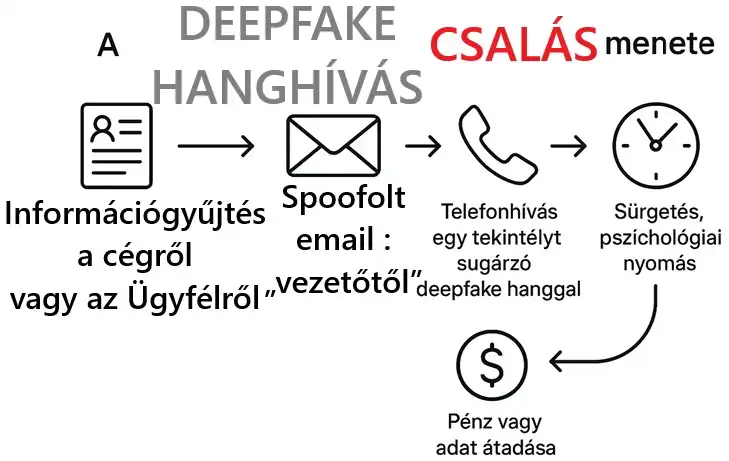

A deepfake veszélyei között a deepfake hanghívás csalás menetéről lépésről lépésre

1. Információgyűjtés a cégről vagy az ügyfélről

A támadók először nyilvános és félig zárt forrásokból (weboldalak, LinkedIn, sajtó, közösségi hálózatok, céges prezentációk) összegyűjtik, ki kinek a felettese, milyen projekteken dolgozik, milyen összegek, határidők, partnerek fordulnak elő. A cél egy olyan történet felépítése, amely a későbbi hívásnál teljesen hihetőnek tűnik.

2. Spoofolt e-mail vagy üzenet a „vezetőtől”

Ezután érkezik egy látszólag ártalmatlan, de kontextust teremtő üzenet. Ahogy írtam, spoofolt e-mail, belső chat, SMS vagy más csatorna, amely a „vezető” nevében érkezik. Nem feltétlenül kér még semmit, csak előkészíti a terepet. Említ egy sürgős ügyet, egy közelgő határidőt vagy egy bizalmas tranzakciót.

3. Telefonhívás egy tekintélyt sugárzó deepfake hanggal

A következő lépés a hívás. A támadó vagy klónozott hangot, vagy egy általános, magabiztos „vezetői tónust”

használ. A hívás időzítése nem véletlen, gyakran nap végén, egy másik nap végén, terheltebb időszakban érkezik, amikor kevesebb energiánk marad a kételkedésre, és inkább a megszokott működésünkre hagyatkozunk (napi rutin).

4. Sürgetés, pszichológiai nyomás

A hívás központi eleme a sürgetés:

✅ „most kell megcsinálni”, „nem ér rá holnap”, „felső-vezetői szintű döntés” és így tovább❗

A támadó arra épít, hogy az áldozat nem akar akadályként viselkedni, és nem mer ellentmondani egy

feltételezett felettesnek. A cél, hogy az illető ne kérdezzen, hanem végrehajtson.

5. Pénz vagy adat átadása

A folyamat végén konkrét kérés is érkezik:

- utalás,

- hozzáférés megadása,

- belépési adatok,

- dokumentumok vagy belső információk továbbítása.

Mire a pénzügyi csalók idáig eljutnak, az áldozat fejében a helyzet már rég lezárt. Úgy érzi a kis szófogadó, az agyát pihentetni szerető, és legfőképp magát biztonságban tudni imádó, hogy a napi rutin szófogadás keretében, csupán egy adminisztratív lépést hajtott végre, nem pedig egy rendkívüli döntést hozott.

De most őszintén, gondoljunk bele, ha az emberi működés alapvetően nem ilyen lenne, akkor az államok eszmerendszere se nagyon alakulhatott volna ki❗

Hiszen ahány állam, annyiféle, de úgy általában, mindegyik földrajzi területre húzott jogrend lényege egy kaptafára megy : gondolkodni az ember helyett, hisz ez az érdekük nem❓😂

Valós példák a deepfake veszélyei világából

A gyakorlatban már több olyan eset történt, ahol deepfake hanggal vagy hasonló módszerrel vettek rá

pénzügyi vagy operatív döntéshozókat nagy összegű utalásokra.

Közös pont, hogy a támadók mindig valamilyen valós üzleti helyzetet használtak fel:

- akvizíciót,

- sürgős számlát,

- partneri elszámolást vagy belső átcsoportosítást.

A csalás utólag azért tűnik „nyilvánvalónak”, mert kívülről nézve már nem érezzük azt a nyomást, amit az áldozat a hívás pillanatában megélt.

📰 De kérlek engedd meg nekem, hogy egy konkrét példával szolgáljak Neked, egy régebbi 2019-es ügy vonatkozásában, ami kifejezetten ☝️ a fenti táblázatom szerint definiált Deepfake hanghívás tipikus esete 👇

Szóval egy brit energiavállalat potom 243 ezer amerikai dolláros átverésének sztorija :

Egy brit energiavállalat vezetőjét felhívta valaki, aki AI‑generált hanggal tökéletesen utánozta a német anyavállalat vezérigazgatójának (CEO) stílusát, hanghordozását. A „főnök” sürgős átutalást kért egy „magyarországi beszállítónak”, összesen €220 000 / $243 000 értékben. A vezető gondolkodás nélkül teljesítette. A hang, a hangsúly, a német akcentus mind stimmelt. A pénz természetesen eltűnt.

Az esettel kapcsolatban több médiaorgánum is szót kapott, de az opciók közül megállapításom forrásaként, akkor most a 🔗 ZDNET -re esett a választásom.

Egyébként az eset és ahogy hírbehozásra került, szintén az alapvető emberi természetre rávilágít. Ami meglátásom szerint az emberek tanulási folyamatait is nehezíti. Azaz, ha valaki elkövet egy szarvashibát, azt szégyenli és nem vallja be.

No persze, itt bejön a képbe ám az is, hogy egy egész vállalatról van szó, hisz a hírforrásban maga a jogi személy lett, nem feltüntetve❗

Tehát az is lehet, hogy az az egy személy bevallotta volna, de a kollektív döntés mégis az volt, borzasztóan nagy presztízsveszteség lenne a cégnek, ha ez nyilvánosságra kerülne, így nevükről hallgatni arany. 😂 Értelemszerűen a hírforrások, beszállító alatt, nem azt értették, hogy tényleges magyar beszállító lett volna az ügyben, inkább egy magyar bankszámla.

Miért működnek ennyire jól a deepfake csalások❓

- Autoritás: az emberek hajlamosak engedelmeskedni annak, akit felettesnek vagy szakértőnek érzékelnek.

- Sürgetés: időnyomás alatt kevesebbet kérdezünk, és inkább a „ne én legyek a szűk keresztmetszet” reflex működik.

- Kontextus: az előzetes üzenetek miatt a hívás beleillik egy már ismert történetbe, így kevésbé tűnik gyanúsnak.

- Digitális távolság: távmunkában, online térben ritkábban ellenőrizzük személyesen, ki áll egy kérés mögött.

Hogyan védekezhetnek a magánszemélyek❓

- Kétkedés „túl sürgős” kéréseknél: ha valaki azonnali pénzügyi vagy hozzáférési döntést kér, mindig gyanakodj.

- kommunikációs közeg váltás: ha bizonytalan vagy, hívd vissza az illetőt egy általad ismert, korábbi elérhetőségén.

- Személyes ellenőrző kérdések: tegyél fel olyan kérdést, amire csak az igazi személy tud válaszolni, de nem publikus információ.

- Ne ossz meg feleslegesen hanganyagot: nyilvános felületeken minél kevesebb, annál jobb, különösen ha a munkád pénzügyi döntésekkel jár.

🤔 Hogyan védekezhetnek a cégek és bankok a deepfake veszélyei cunamijában❓

Fontos kihangsúlyoznom, hogy ezek a metodikák csak jogi személyekre vonatkozzanak, itt van értelmük az ilyen intézkedéseknek❗

Többlépcsős hitelesítés (MFA)

Érzékeny műveleteknél (utalás, hozzáférés, jogosultságmódosítás) a hang vagy e-mail soha ne legyen elég.

Kötelező legyen egy második csatornán történő jóváhagyás, például külön alkalmazásban vagy fizikai tokennel.

Utalási protokollok (két jóváhagyó)

Nagy összegű vagy szokatlan tranzakciók esetén legyen kötelező két, egymástól független jóváhagyó.

Ez megtöri azt a helyzetet, ahol egyetlen embert lehet pszichológiai nyomással döntésre kényszeríteni.

Dolgozók oktatása

A munkatársaknak nemcsak az IT‑biztonsági szabályokat kell ismerniük, hanem a manipulációs mintázatokat is, ilyenek például a deepfake veszélyei közötti trükkök esetén a sürgetés, titoktartásra hivatkozás, „felülről jött” utasítás. Ha ezeket az emberek felismerik, nagyobb eséllyel mernek kérdezni vagy nemet mondani. A szakma angolul ezt „social engineering awareness” témába sorolja.

Deepfake-detektáló rendszerek

Bizonyos környezetekben érdemes olyan megoldásokat használni, amelyek elemzik a hanghívásokat és

próbálják azonosítani a mesterségesen generált beszéd jellegzetességeit. Ezek nem tévedhetetlenek,

de plusz védelmi réteget adhatnak.

Ez a gondolatom itt egyébként annak adaléka, hogy betámadhatnak egy fegyverrel (AI technológia), akkor azzal a fegyverrel védekezz. Igaz, megerősíti évekkel ezelőtti gondolatom, ez az amúgy most még csak „AI” korántsem lesz mindig ingyenes, sőt ha a hatékonyságra hajtunk, igazából már most sem. Amikor tehát a deepfake veszélyei ellen technológiai stratégiánkat kialakítjuk, akár a védelmi pénz tipikus esete is lehet.

Hívásellenőrzési szabályok

Legyen egyértelmű, dokumentált szabályzat arra, hogy telefonon keresztül milyen típusú kéréseket

nem lehet teljesíteni (például új számlaszám, jelszó, hozzáférés, nagy összegű utalás). Ha a szabály az, hogy ilyen kérésre mindig kommunikációs közeg váltás történik, a támadó sokkal nehezebb helyzetben van.

👋 Összegzés: a deepfake veszélyei egyre nőnek

Szóval készülj fel❗

A deepfake veszélyei az alkalmazott technológia lehetőségek nem jövőbeli fenyegetések, hanem a jelen része. De persze nem a technológiát kell üldözni, hanem a védekezést kell megtanulni. Különösen az Ai hangklónozás, a manipulált hívások és a pszichológiai nyomás kombinációja valós pénzügyi és reputációs kockázatot jelent. A védekezés kulcsa nem egyetlen „csodamegoldás”, hanem több réteg együtt.

Technikai kontrollok, jól kialakított folyamatok és tudatos, kérdezni és persze bevallani merő emberek kellenek a deepfake veszélyei minimalizálásához. Aki ezt időben felismeri, nem a félelemre épít, hanem a felkészültségre. 🙏Remélem érdekes volt számodra írásom, és mondjuk a 🔗pénzügyek témám bugyrában ismét csak velem tartasz.

A világ globális működését feltérképező, s annak összefüggéseit megérteni óhajtó generalista vagyok. Célom nem más, mint az ismeretterjesztés.