Így tiltsd le a rossz robotokat

Rossz robotok és jó robotok

A rossz robotok ellenpéldája a jó robotok, rendszerint kizárólag hasznos crawler funkciót töltenek be. Bejárják a weboldalakat. Ezt azért teszik, hogy táplálni tudják a mögöttük lévő keresőgép szolgáltatását (amelyek nemcsak általánosak, hanem célorientáltak is lehetnek), azaz a felhasználóknak jobb élmény nyújtására törekednek.

A SEO témán belül, most szeretnék egy kicsit a biztonsággal foglalkozni, s nagyon röviden bemutatni azt, hogy miként tudjuk a rosszindulatú robotokat, ha úgy tetszik levakarni a webszerverünkről, illetve látogatásaik nyomát, eltüntetni a Google Analytics statisztikánkból.

A rossz robotok ismérve

Elég gyakran látogatják meg a kiszemelt áldozatot (weboldal), de a látogatásuk pár másodpercnél nem tart tovább, s tevékenységük „gazdagítja” a statisztikában a visszafordulások arányának százalékos értékét. Ezt a problémakört egyszer már megemlítette 2017-ben az Origo – „A robotok elfoglalták az internetet” című írása is, s azóta a webstatisztikákban lévő ezzel releváns számok, tovább nőttek.

Ahogy a fenti grafikonon is látható, mivel hasznos funkciót nem végeznek, ellentétben a jó robotokkal (például Google, Bing) ezért valamivel nagyobb energiát fektetnek, a kizárólag nagyobb forgalmat lebonyolító weboldalakba.

A rossz robotok célja

A rossz botokat számos rosszindulatú feladat elvégzésére programozták! Követő elemként működnek, és főként csalók, kiberbűnözők és különféle illegális tevékenységeket végző rosszindulatú felek használják az ilyen algoritmusokat. Ugyanakkor direkt támadás áldozatai is lehetünk akár az egyik üzleti életben szereplő versenytársunknak köszönhetően, aki azért küldhet weboldalunkra ilyen robotot, hogy eltulajdonítson tartalmakat, például termékleírásokat, híreket, különböző termékekkel kapcsolatos árazási információkat és katalógusokat. De utazhatnak a weboldalunk forgalma következtében generálódó felhasználók által létrehozott tartalmakra, közösségi űrlapokra, véleményekre, fogyasztási szokásokra is.

Amikor nagyon rövid időn belül több ezer oldallátogatást végeznek ezek a rosszindulatú robotok, akkor megterhelik a webszervereket és megfojtják a rendelkezésre álló sávszélességet, lelassítva a webhelyet a valódi felhasználók élményét ezzel tönkre téve.

Hogyan szűrhetjük ki a rossz robotokat a statisztikából?

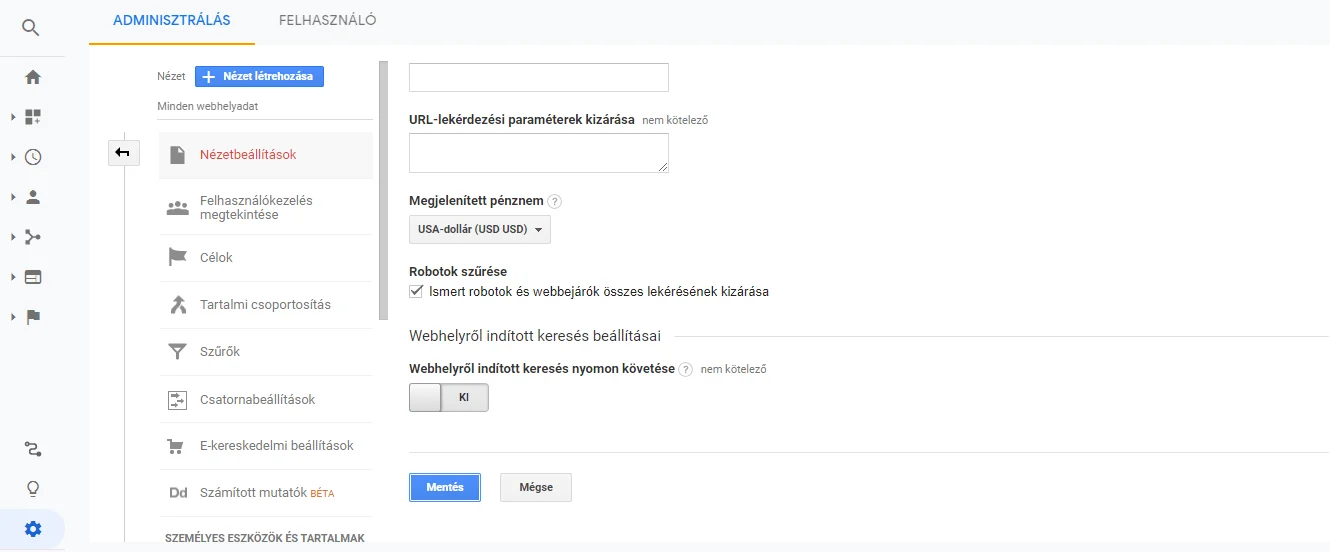

Természetes, ha már a Google Analytics követőkódot beágyazzuk weboldalunkba, akkor elvárjuk, hogy pontos és tiszta látogatottsági adatokat kapjunk, valós emberektől, a tevékenységünk iránt érdeklődőktől. A Google Inc. elég jó adatbázissal rendelkezik már, a kifejezetten Bad Bot kategóriába tartozó elemekről.

A fenti képnek megfelelően, ha bejelentkezünk a Google Analytics felületére, akkor kattintsuk, a bal alsó sarokban található fogaskerék figurára, ami egyébként mindenhol a beállításokra enged asszociálni. Mindenképpen pipáljuk ki az „ismert robotok szűrése” részt. Ennek köszönhetően, ha bár a jó robotok látogatása hasznos weboldalunknak, de úgy alapvetően a robotok látogatása, hisz nem emberi tényezők, a statisztikákban érdektelenek.

Hogyan detektálhatjuk webszerverünkön a rossz robotokat?

Akinél a fent említett pipa nem szerepel, annak apróbb támpontot a Google Analytics nyilván tud szolgáltatni, de úgy gondolom, hogy ez csak ahhoz elég, hogy mint szemét a statisztikai adatok zavarjanak bennünket (ezért is javasoltam a pipát), ahhoz viszont édeskevés, hogy a rossz robotok aktivitásait 100% feltudjuk térképezni és a szükséges gyomlálásukat elvégezni.

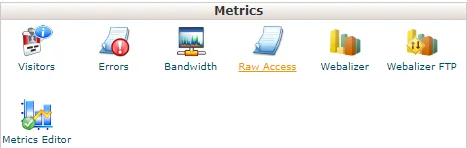

Szerintem a rossz robotok felkutatására az egyik legjobb ötlet, ha a Cpanel szolgáltatását vesszük igénybe. Rendszerint ez minden webszerveren elérhető, amely több különböző kliens számára biztosít, úgynevezett virtuális webszerver szolgáltatást. Javaslom, jelentkezünk be ebbe a Cpanel-be, biztonsági okokból azon a porton, amellyel SSL szintű bejelentkezést tudunk végrehajtani. Ha bent vagyunk, akkor a Metrics részre keressünk rá, s azon belül a Raw Access lesz számunkra hasznos.

A Raw Access mint hasznos funkció megértése!

A Raw Access segítségével feltudjuk kutatni az összes létező aktivitást, amely mint látogatás, a weboldalunkat érte (IP címek alapján, s a bot látogatók neveit is megkapjuk). Ezt a listát letudjuk tölteni a szerverünkről, egy GNU/Linux világában nagyon jól elhíresült és bevált .gzip tömörítési formátumban. Nincs semmi probléma, ha még sosem hallottál erről, a Windows ezt automatikusan kezeli, szóval ha letöltötted, csak rákattintasz, és már nézheted is az ugyan nem csicsás, de mégis beszédes adatsorokat.

Egy gyakorlati példában megmutatom, milyen az az adatsor, amely egy BOT látogatást prezentál (ez a példa itt egy jó botot mutat)

157.55.39.59 – – [30/Jun/2020:15:43:22 +0300] „GET /kriptodevizak-funkcio/ HTTP/1.1” 200 44445 „-” „Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)” – látható, hogy itt a Kriptodevizák funkció című cikkemet a bingbot meglátogatta. Ez határozottan egy jó bot, hiszen a Microsoft keresőgépe, amely ha nem is annyira jó, mint a Google, de azért közismert, szóval onnan sem ártanak találatok, így örülök neki, hogy megtetszett neki a cikkem. Mivel jó bot, szorgalmasan végig is nézett mindent, jó sok időt töltött nálam 🙂

Hogy engedünk egy robotnak vagy sem, szuverén döntésünk

Szintén mutatnék egy gyakorlati példát az adatsorból, amely az én szubjektív véleményem alapján Rossz Bot, ugyanakkor a szakma egyelőre nem sorolja oda, de én mégis inkább letiltottam, mert látogatása nekem, teljesen felesleges!

/elmenyek-amit-szicilia-nyujthat/ HTTP/1.1″ 200 31109 „-” „pimeyes.com crawler”

95.217.118.99 – – [04/Jul/2020:20:45:19 +0300] „GET – először is látható az IP címe, ami azért számomra megkérdőjelezi a hasznos crawler kategóriát, mint ahogy az azonosítójában feltünteti magát. Az IP cím egyértelműen a clients.your-server.de felé mutat, ahonnan tucatszámra szoktak a weboldalak felé a spam-ek érkezni. Ugyanakkor a pimeyes.com azonosító sem csalás. Ez egy olyan robot, ami arcfelismerő adatbázist kíván összehozni.

Mivel jelenleg blogom semmi olyan adatot nem tartalmaz, amely ennek a robotnak a rendeltetésével releváns lenne, ezért inkább letiltottam. Jobb neki is, meg nekem is alapon 🙂 Blogomnak ugyan elég nagy a látogatottsága, de rendszeres gyomlálást végzek a szerver információi alapján, így kártékony hatásukat nálam nem tudják kifejteni.

A robot mentségére legyen azért mondva, hogy tényleg a rendeltetése szerint járt el, mert blogomnak kizárólag azok a helyei érdekelték, ahol fotók vannak. A Szicíliáról írt cikkemben szép fotók vannak, s nem is csoda, hogy tetszett a botnak, hiszen úgy láttam, Facebook™ hálózaton is 400 felett osztották meg 😉 Csak hát ügye ez a szegény bot főként emberi lények arcfotói után kutathatott. Egyébként megjegyzem ez a pimeyes.com nem egy rossz dolog, mert az lenne a lényege, hogy Te feltöltöd a fotódat, s Ő megmondja Neked, hol, merre vagy megtalálható az Interneten. Ennek köszönhetően hasznos lehet azoknak akik kíváncsiak arra, hogy írásbeli engedélyük nélkül az arcfotóikat hol szerepeltetik, s esetleg kik 🙂

Hogyan távolíthatjuk el webszerverünkről az erőforrásainkat feleslegesen felőrlő robotokat?

Nos ügye a robotoknál az etika azt diktálja, hogy a weboldaladnak először nézze meg a robots.txt nevű fájlját és az ott található direktívákat magára nézve érezze kötelezőnek. Csak, hogy a Rossz Botok, pontosan azért rossz botok, mert a bankrabló is tudja, hogy nem szabad bankot rabolni, mégis megteszi. Szóval intelmekkel nem lehet menni semmire, radikálisabb megoldásnak tűnik a .htaccess szintű fellépés. Javaslom egyébként, hogy ez a .htaccess fájlod csak olvasható formában legyen jelen, hogy csak Te tudd szerkeszteni a Cpanel-en keresztül. Ez egy hasznos biztonságtechnikai lépés, mert a különböző tartalomkezelő rendszerek meg a hozzájuk tartozó bővítmények, előszeretettel beleírogatnak, s akár a rendszered is fejre állhat.

Szóval ha detektáltuk a rossz botot, akkor a .htaccess -ben az alábbiak szerint letilthatjuk:

SetEnvIfNoCase User-Agent ^$ bad_bot #A rossz robotok miatt!

SetEnvIfNoCase User-Agent „^AITCSRobot/1.1” bad_bot<Limit GET POST HEAD>

Order Allow,Deny

Allow from all

Deny from env=bad_bot

</Limit>

Ebben a példában az AITCSRobot/1.1 nevű rossz robot lett letiltva. Van egyébként egy olyan hasznos adatbázis, amely rendszeresen frissül a felhasználói visszajelzések alapján : Bot Reports címen elérhető! Ha tehát van egy nagy forgalmas weboldalunk, akkor ebből az adatbázisból akár prevenció jelleggel is eljárhatunk.

A világ globális működését feltérképező, s annak összefüggéseit megérteni óhajtó generalista vagyok. Célom nem más, mint az ismeretterjesztés.